新聞資訊

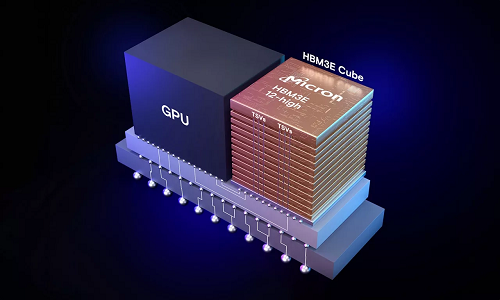

9 月 6 日消息,美光在本月發布的技術博客中表示,其“生產可用”(IT之家注:原文 production-capable)的 12 層堆疊 HBM3E 36GB 內存現正向主要行業合作伙伴交付,以在整個 AI 生態系統中進行驗證。

美光表示,其 12 層堆疊 HBM3E 容量較現有的 8 層堆疊 HBM3E 產品高出 50%,允許 Llama-70B 這樣的大型 AI 模型在單個處理器上運行,可避免多處理器運行帶來的延遲問題。

美光 12 層堆疊 HBM3E 內存具有 9.2+ Gb/s 的 I/O 引腳速率,可提供 1.2+ TB/s 的內存帶寬。美光同時還宣稱該產品較友商 8 層堆疊 HBM3E 競品功耗明顯更低。

HBM3E 并非孤立產品,而是集成在 AI 芯片系統中,這仰賴于內存供應商、產品客戶與 OSAT 企業的通力合作。而美光是臺積電 3DFabric 先進封裝聯盟的合作伙伴成員。

臺積電生態系統與聯盟管理處處長 Dan Kochpatcharin 近日表示:

臺積電與美光一直保持著長期的戰略合作伙伴關系。作為 OIP 生態系統的一部分,我們密切合作,使美光基于 HBM3E 的系統與 CoWoS 封裝設計能夠支持客戶的人工智能創新。

發布日期: 2025-02-19

發布日期: 2024-07-17

發布日期: 2024-06-20

發布日期: 2024-10-25

發布日期: 2024-04-26

發布日期: 2024-04-23

發布日期: 2024-04-12

發布日期: 2024-09-04

發布日期: 2025-05-19

發布日期: 2025-05-19

發布日期: 2025-05-19

發布日期: 2025-05-19

發布日期: 2025-05-19